Введение

Настоящий курс посвящён некоторым аспектам создания изображений и анимации при помощи вычислительных устройств.

Вообще говоря, генерируемые при помощи компьютера изображения можно поделить как минимум на два класса:

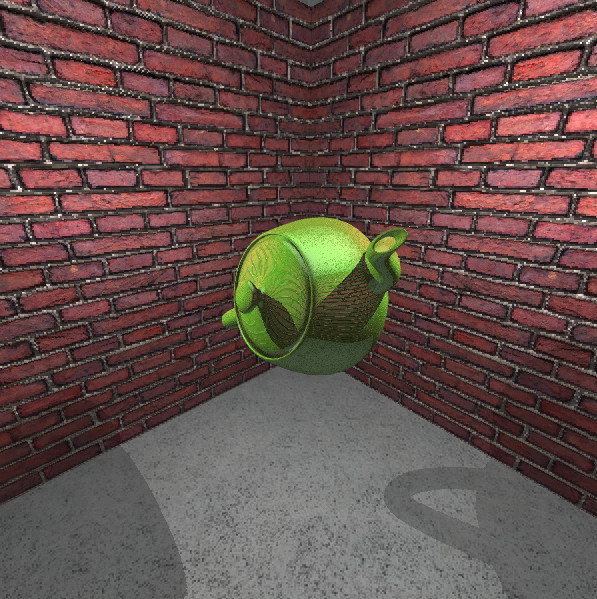

- условно «фотореалистичные» — те, для генерации которых требуются значительные вычислительные ресурсы (соответствующие минутам, часам и даже дням вычислений)

- условно «интерактивные» — те, которые можно сгенерировать на доступном оборудовании за доли секунды

Принципы создания изображений и алгоритмы их визуализации для этих классов весьма непохожи друг на друга. Мы будем говорить почти исключительно о втором классе изображений, а содержание этого курса весьма сильно привязано к возможностям графических процессоров второй половины 2010-х (говоря точнее, — к возможностям графических процессоров игровых приставок 8-го поколения).

При этом отдельно отметим, что этот курс посвящён не тому, как при помощи тех или иных программных продуктов получить желаемое изображение, а тем алгоритмам, которые набор входных данных (какие-то числа, представляющие информацию о структуре изображаемого объекта) преобразуют в итоговое изображение.

История

В процессе написания

Инструментарий

Для иллюстрации рассматриваемых алгоритмов мы будем использовать т.н. «веб-технологии» — те средства, которые предоставляют веб-браузеры (которые уже весьма давно из средств отображения гипертекстовых документов превратились в почти полноценные операционные системы).

Язык Javascript

Родным языком программирования (родным в том смысле, в котором таковыми являются разнообразные «ассемблеры» для реальных CPU) для браузеров является Javascript.

Javascript является типичным процедурно-ориентированным скриптовым языком. Его семантика, например, весьма близка таким языкам как Python, PHP, Lua.

Впрочем, у Javascript есть несколько уникальных особенностей, о которых следует упомянуть.

Реактивная модель исполнения

Обычно языки программирования работают по императивной модели: один (или несколько) исполнитель последовательно выполняет команды, из которых состоит программа. Когда команды закончились, программа завершается.

Для Javascript ситуация несколько иная:

- исполнитель всегда ровно один

- но он умеет находиться не только в состоянии исполнения команд, но и в состоянии ожидания

- выводят его из состояния ожидания какие-то внешние события, с которыми связана функция-обработчик

- выйдя из состояния ожидания, исполнитель полностью выполняет функцию-обработчик, не прерываясь и не переходя к исполнению других функций-обработчиков до завершения выполнения текущей функции

По похожей реактивной модели работают центральные процессоры за тем исключением, что в них либо нет никакой «очереди событий», либо же она максимально примитивна и сильно ограничена в размере.

Отсутствие стандартного окружения

В Javascript есть минимальный набор стандартных средств для работы со встроенными в язык типами данных. Весь же набор средств для общения со внешним миров не стандартизирован и определяется конкретной реализацией языка.

Тем не менее, в подавляющем большинстве случаев используется одно из двух «окружений»:

- «браузерное»

- «серверное»

Первое доступно во всевозможных браузерах, и именно с ним мы будем работать (для разных браузеров оно немного разное, но, к счастью, различия не слишком существенны).

Второе — это проект Node.js, позволяющий использовать Javascript как язык для управления ОС.

Не лишним будет сказать о проектах типа Electron, которые совмещают в себе два вышеупомянутых окружения и используются для кроссплатформенных приложений с нетривиальным пользовательским интерфейсом.

Упор на функциональное программирование

Несмотря на то, что Javascript копирует синтаксис языков C, C++, Java и им подобных, а семантикой очень напоминает Python, типичные методологии программирования на нём существенно отличаются от таковых для тех самых C, C++, Java, Python и т.п.

Например, Javascript был одним из первых языков программирования, впитавших монадный подход к асинхронному программированию (пришедший из экосистемы языка Haskell). И вообще изначально задумывался как язык семейства ЛИСП с джаваподобным синтаксисом.

Как следствие, программы на Javascript очень активно используют функции, которые получают на вход другие функции и собирают из них какие-то ещё функции. Более того, в лучших традициях функциональных языков программирования функции в Javascript используются не только как средство изоляции блоков кода, но и как средство модуляризации программы (полноценная стандартизированная поддержка модулей появилась в языке не так давно, и до сих пор многие библиотеки ей не пользуются; кроме того, стандартные модули не являются «объектами первого класса» в отличие от функциональных).

Где почитать подробнее про язык

Рекомендуем два источника:

- MDN — справочник не только по Javascript, но и вообще по всем веб-технологиям

- learn.javascript.ru — неплохой (правда, малость многословный) учебник на русском языке

Также в следующем подразделе дана очень краткая справка по наиболее важным аспектам языка.

Немного о Javascript

Это — очень краткая справка по языку. К тому же, немного устаревшая (она писалась в 2016 году; сейчас я её обновил, но только в совсем неактуальных моментах).

Где взять?

В случае с языком Javascript компилятор долго искать не нужно: в этой роли способен выступать любой достаточно современный браузер. Как и в случае большинства языков программирования, у Javascript есть два режима выполнения: интерактивный построчный и неинтерактивный, исполняющий программу целиком.

В качестве интерактивного режима может выступать Javascript-консоль, находящаяся среди Инструментов Разработчика (Developer Tools) браузера.

Выполнить программу целиком можно одим из следующих способов:

-

Включить внутрь html-документа тег

script. Внутри этого тега должна находиться программа на Javascript. Распознавание html для содержимого тегаscriptотключено! -

Использовать пустой тег

scriptс аттрибутомsrc=путь_к_файлу. Например, так:

<script src="foobar.js"></script>

Отметим также, что существует популярная альтернатива браузерам как Javascript-платформам — Node.js. Обычно её используют тогда, когда по тем или иным причинам удобно исполнять один и тот же кусок кода как на стороне пользователя, просматривающего веб-страницу, так и на стороне сервера, обслуживающего эту страницу. Впрочем, последнее время Node.js для чего только не используют (в том числе — используют как цель для кросскомпиляции программ на других языках).

Основные характеристики языка

Javascript является слабо динамически типизированным языком. Динамическая типизация означает, что типы проверяются только на этапе выполнения программы, но не на этапе компиляции (более того, переменные в Javascript не имеют типов).

Слабая же типизация означает, что даже выражения, которые не типизируются никаким адекватным образом (например, сумма числа и текста) всё равно вычисляются после неявного преобразование каких-то частей выражения к другому типу.

Отметим, что для тех случаев, когда хочется адекватной системы типов, позволяющей выражать часть инвариантов программы и проверять их на этапе компиляции, существует Typescript — система опциональной строгой статической типизации для Javascript.

Основные синтаксические конструкции

Javascript получил своё название от языка Java, у которого он позаимствовал существенную часть синтаксиса (но не семантики). Язык Java, в свою очередь, синтаксис позаимствовал у C++.

Начнём с объявления переменных. Как ни странно, но это — весьма сложная часть языка. В Javascript есть четыре вида объявления переменных:

foo = 3; // глобальная переменная

var foo = 4; // переменная, локальная для функции

let foo = 5; // переменная, локальная для блока

const foo = 6; // неизменяемая переменная, локальная для блока

Обратите внимание! Объявление глобальной переменной по своему виду совпадает с операцией присваивания. Это — распространённый источник ошибок!

Все var-объявления переменных, где бы они ни находились, переносятся в

начало функции, их содержащей. Это поведение более-менее аналогично

поведению языка Python в аспекте локальных переменных.

Наконец, let и const — предпочтительный способ объявления

переменных. Остальные два существуют только для обратной совместимости

с кодом, написанным до 2015 года. Причём настоятельно рекомендуется

использовать const везде, кроме тех случаев, когда let необходим.

Функции в Javascript задаются при помощи лямбда-выражений. Например:

const sayHello = (name) => { alert("Hello, " + name); };

Сразу скажем, что обе точки-с-запятой здесь необязательны: при их отсутствии компилятор сам поставит их там, где посчитает нужным. К сожалению, алгоритм расстановки точек-с-запятой довольно примитивен и неотключаем. Это приводит к проблемам вида:

const addNumbers = (x,y) => {

return // точка-с-запятой будет поставлена здесь!

x+y;

};

или же

const something = x => { // единственный вход можно не брать в скобки

const foo = 2

( generateFoo(foo) )(x) // эта строчка является потенциальным продолжением предыдущей

// поэтому точка-с-запятой в конце предыдущей строчки поставлена не будет

}

Также допустимы объявления функций вида

function foo(x,y,z) { ... }

Все такие объявления обрабатываются компилятором на этапе чтения программы до её выполнения, поэтому, в частности, корректно работает следующее:

sayHello(); // код может встречаться и вне функций!

function sayHello() { ... } // функция объявлена после её использования

Управляющие конструкции if, while, for, switch, break, continue, return

в Javascript работают почти полностью аналогично соответствующим конструкциям из C.

Команда goto отсутствует, зато есть возможность помечать циклы метками и

выходить сразу из нескольких циклических уровней:

outer: for (let i = 0; i < 10; i += 1) {

for (let j = 0; j < 10; j += 1) {

console.log(i+j);

if (i > j) { break outer; }

}

}

Различные виды данных

В первом приближении в Javascript есть 8 «типов» данных:

boolean, null, undefined, number, string, object, bigint, symbol.

Тип boolean содержит два значения: true и false. Тем не менее,

любой объект может быть преобразован к этому типу.

Ложными считаются: false, число 0, число -0, число NaN, null, undefined,

пустой текст. Всё остальное считается истинным.

Типы null и undefined содержат по одному (одноимённому) значению.

Различие между ними следующее: предполагается, что null — вполне

корректное значение, которое программист может использовать в своих целях,

а undefined — обычно признак ошибки в коде. Впрочем, иногда

у них есть и другие назначения. Например, при преобразовании объектов

в формат JSON поля со значением null остаются, а

со значением undefined — нет.

Числа в Javascript обычно имеют тип number — аналог double из языка C.

А именно, это — числа с плавающей точкой двойной точности.

В связи с этим с ними нужно соблюдать осторожность: арифметика с плавающей

точкой порой значительно отличается по поведению от арифметики целых чисел.

Есть ещё тип bigint. Литералы этого типа имеют суффикс n. Например,

123n. Это — целые числа произвольного размера. Аналогичны целым

числам в Python.

Тексты типа string представляют собой неизменяемые массивы символов в

кодировке UTF-16 (это означает, что некоторые символы занимают по два

«места»). К отдельным символам можно обращаться при помощи

квадратных скобок

или же метода charAt (например "foobar".charAt(2)). Длина текста

хранится в поле length ("foobar".length равно 6). Текстовые литералы

можно обозначать как одинарными, так и двойными кавычками — разницы между

ними нет. Также есть обратные кавычки, внутри которых:

- можно переходить на новую строчки — ошибки компиляции не будет

- можно вставить текстовое представление значения любой формулы — эту

формулу нужно взять в доллар с парой фигурных скобок:

${формула}

Текст можно преобразовать в число функциями parseInt, parseFloat и BigInt.

Тип symbol используется не слишком часто, поэтому мы не будем на нём отдельно

останавливаться.

Всё остальное (в том числе функции и массивы) считаются представителями типа object.

Поскольку объекты бывают изменяемыми, очень важно понимать семантику

операции присваивания. В Javascript присваивание даёт объекту новое имя

(в точности как в Python):

a = [1,2,3];

b = a;

b[1] = 4; // теперь a[1] -- тоже 4, поскольку b и a именуют один и тот же массив

Объекты представляют собой наборы пар ключ-значение, где ключ — произвольный текст, а значение — произвольная единица данных. Литералы объектов оформляются фигурными скобками, ключи и значения разделяются двоеточиями, а пары ключ-значение — запятыми.

Например, так:

const someObject = {

foo: { // ключи не обязательно брать в кавычки

bar: 123,

baz: 456

},

"quuz": 789,

};

Получить доступ к полям такого объекта можно как при помощи квадратных

скобок (например, someObject["foo"]), так и при помощи точки (например,

someObject.foo). Квадратные скобки более универсальны (работают, например,

для ключей, состоящих из цифр), но никак не обрабатываются различными

оптимизаторами и минификаторами кода (впрочем, оптимизаторы и минификаторы

не являются частью языка, да и используются зачастую только для

того, чтобы убрать из кода все пробелы и комментарии).

В заключение пара слов о массивах. Массивы ведут себя так, как будто

они являются объектами с ключами "0", "1", "2" и так далее.

Тем не менее, для них есть специальная поддержка со стороны языка.

Литералы массивов выделяются с двух сторон квадратными скобками.

Длина массива хранится в поле length. Доступ к элементам осуществляется

при помощи квадратных скобок. Наиболее простой способ скопировать массив:

воспользоваться методом slice (foobar.slice() создаёт копию

массива, именуемого переменной foobar).

Метод push позволяет добавить элементы в конец массива (например, foobar.push(1,2,3)

добавляет элементы 1, 2, 3 в конец массива, именуемого foobar). Можно

добавлять элементы и просто при помощи квадратных скобок и присваивания:

foobar[foobar.length] = 1;

foobar[foobar.length] = 2;

foobar[foobar.length] = 3;

// эквивалентно foobar.push(1,2,3)

Циклы «foreach»

Кроме сиподобного цикла for в Javascript есть более лакончиные

for (let/const переменная in формула)for (let/const переменная of формула)

Оба они работают примерно как for из Python: сначала вычисляется

значение формулы, а затем, если это значение имеет тип object:

for inпроходится по всем ключам объекта (кроме тех, которые помечены как «неперечисляемые»)for ofзапускает специальный механизм итерации (для произвольно взятого объекта этот механизм не определён; зато определён, например, для массивов, для которыхfor ofв основном и используется)

Сравнение объектов

Отдельный раздел мы посвятим операторам сравнения == и === (и их отрицаниям

!= и !==).

Различие между ними простое: === проверяет только равенство внутри

одного типа; объекты разного типа он считает разными; == дополнительно

производит преобразование типов. Поскольку запомнить семантику оператора ==

весьма сложно, не рекомендуется его использовать кроме как для

сравнения чисел с текстами, состоящими из цифр. Поэтому мы опишем только

действие ===.

- булевы значения сравниваются естественным образом

nullравноnull, то же самое — сundefined- тексты сравниваются посимвольно

- числа сравниваются в соответствии с правилами арифметики с плавающей точкой

- объекты равны только при равенстве указателей (т.е. когда это физически один

и тот же объект в памяти компьютера); в частности, обычно

[1,2,3]не равен[1,2,3]!

Оператор typeof

В Javascript есть оператор typeof, который позволяет узнать тип объекта.

У него есть две особенности:

typeof null === 'object', несмотря на то, что настоящий типnullназываетсяnulltypeof функция === 'function', хотя функции имеют типobject

Впрочем, обычно typeof используется для того, чтобы отличить текст от числа.

JSON

Javascript породил такой текстовый формат представления данных как JSON. Каждая единица данных в JSON — это одно из:

- число (оформляется стандартным образом)

- текст (оформляется при помощи двойных кавычек)

- список (оформляется при помощи квадратных скобок и запятых)

- объект (оформляется при помощи фигурных скобок и запятых; запятые разделяют пары

ключ : значение, гдеключ— это текст, азначение— произвольный JSON) - булево значение:

falseилиtrue - значение

null

Сам Javascript поддерживает в качестве литералов некоторое надмножество JSON.

Например, объект, соответствующий JSON

{ "foo" : "bar", "baz": { "quuz": 42 } }

в Javascript можно записать как

{ foo: `bar`, baz: { quuz: 42, }, }

Для преобразования между Javascript-объектами и JSON существуют функции

JSON.parse (из JSON в JS) и JSON.stringify (из JS в JSON).

Зачастую JSON.stringify — наиболее простой способ сравнить между

собой сложные объекты (например, два массива). К сожалению, числа

типа bigint не поддерживаются этой функцией.

Функции как замыкания

Если функция объявляется в контексте каких-то переменных и их использует, то эти переменные остаются живы всё то время, пока жива эта функция.

Например, работает следующий код:

function makeAdder(toAdd) {

return x => toAdd + x; // тело вида { return формула; } можно заменить просто на эту формулу

}

const foo = makeAdder(3);

console.log(foo(1)); // печатает 4

console.log(foo(2)); // печатает 5

Более того, подобным образом можно сделать «объект» с изменяемым состоянием:

function makeVar(init) {

let myVar = init;

return [

() => myVar,

(newVal) => { myVar = newVal },

];

}

const [ getFoo, setFoo ] = makeVar(42);

console.log(getFoo()); // 42

setFoo(24);

console.log(getFoo()); // 24

И даже — «модуль первого класса»:

function makeLibrary(/*какие-то параметры*/) {

const FOO = /*...*/;

const BAR = /*...*/;

function someFunc1(/*...*/) { /*...*/ }

function someFunc2(/*...*/) { /*...*/ }

function someFunc3(/*...*/) { /*...*/ }

return { someFunc1, someFunc2, someFunc3 };

}

Можно для каждого набора параметров создать свой экземпляр «библиотеки» и одновременно пользоваться несколькими такими экземплярами. Иногда это бывает очень удобно!

Демонстрация

Сейчас мы покажем средства работы с графикой, предоставляемые браузерным окружением.

Полный код примера доступен по ссылке.

Простейший растровый редактор

Мы реализуем растровый редактор: программу, позволяющую редактировать изображение путём изменения цветов его пикселей.

Точка входа: HTML-страница

Основной режим работы браузера: просмотр файлов, написанных на языке HTML. Эти файлы описывают общую структуру «документа» (этим словом называется то, что браузер в итоге рисует).

Также в HTML-файле могут содержаться части, написанные на языке CSS (задают по большей части внешний вид тех или иных компонент документа), и части, написанные на языке Javascript (описывают поведение документа в ответ на действия пользователя или же иные «события»).

Нам сейчас (и далее) не будут требоваться никакие особенности HTML и CSS, поэтому ограничимся самым минимумом:

<!doctype html>

<meta charset="utf8">

<title>Микропэйнт</title>

<script src="main.js"></script>

<canvas id="CANVAS"></canvas>

Этот текст нужно сохранить в какой-нибудь текстовый файл. Желательно, чтобы

название файла оканчивалось на .html, а текст кодировался при помощи utf8.

Первая строчка задаёт версию языка HTML.

Вторая — указывает кодировку файла.

Третья — название, которое браузер печатает на соответствующей вкладке. Можно её и не писать.

Четвёртая — указывает, что нужно запустить программу, которая содержится

в файле main.js. Хотя HTML позволяет писать Javascript-код между открывающим

«тегом» <script> и закрывающим </script>, лучше всё же

этот код писать в отдельном файле. И Вам будет проще, и текстовому редактору,

которым Вы пользуетесь.

Пятая строчка описывает единственную компоненту документа — элемент

canvas. Этот элемент предоставляет различные способы рисовать на нём

изображение при помощи программы. «Атрибут» id="CANVAS"

задаёт идентификатор элемента: именно по этому идентификатору мы получим

доступ к элементу внутри программы.

Событие load

Вообще говоря, Javascript обычно исполняется в ответ на те или иные события. А именно, считав программу из файла, браузер сперва выполняет весь код, находящийся вне определения функций, а затем переходит в режим ожидания.

Режим ожидания прерывается только если происходит что-то. Если при этом к этому чему-то была привязаны какие-то функции, эти функции выполняются друг за другом. При этом выполнение какой-либо из этих функций не может быть прервано другим событием (событие откладывается в очередь, откуда затем достаётся браузером в подходящий момент).

Одним из возможных событий является load. Оно происходит в тот момент, когда

браузер заканчивает формирование документа. После этого события из документа

можно получить доступ к любому элементу, описанному в HTML.

Функцию-обработчик этого события можно задавать путём изменения глобальной

переменной onload (есть также метод .addEventListener, при помощи

которого можно задать несколько обработчиков одному и тому же событию,

но его использование чревато трудноуловимыми ошибками и, по-хорошему,

требует организации системы регистрации обработчиков событий).

Начнём с простого:

onload = () => {

const canvas = document.getElementById("CANVAS");

const ctx = canvas.getContext("2d");

ctx.fillStyle = 'red';

ctx.fillRect(0, 0, ctx.canvas.width, ctx.canvas.height);

}

Первая строчка функции получает элемент с идентификатором CANVAS.

Вторая — получает от этого элемента «контекст» 2d. Под

термином «контекст» понимается набор функций для работы

с холстом и некоторое внутреннее состояние, обеспечивающее взаимное влияние

этих функций друг на друга.

Кроме контекста 2d холст предоставляет ещё контексты webgl и webgl2,

которые используются для управления GPU в соответствии со стандартом

OpenGL ES.

Описание контекста 2d можно посмотреть, например, на

MDN.

Далее демонстрируется метод .fillRect, рисующий сплошной прямоугольник.

Управляется поведение этого метода полем .fillStyle, которое позволяет

задать цвет прямоугольника. Цвет можно задавать одним из следующих

способов:

- названием

- в 16-ричной системе счисления по маске

#RGB(например,#a0e) - в 16-ричной системе счисления по маске

#RGBA(например,#a0ef) - в 16-ричной системе счисления по маске

#RRGGBB(например,#aa00ee) - в 16-ричной системе счисления по маске

#RRGGBBAA(например,#aa00eeff) - в десятичной системе счисления

rgb(170,0,238)илиrgba(170,0,238,1.0) - ещё несколькими способами

Отметим, что альфа-канал используется для линейной интерполяции между старым и новым цветами по формуле (для каждой из RGB-компонент)

\[\alpha x + (1-\alpha) X\]

где \(x\) — старое значение компоненты, а \(X\) — новое. Это — самый частый, но далеко не единственный способ использования альфа-канала.

Также отметим, что ctx.canvas.width и ctx.canvas.height можно было

бы заменить на просто canvas.width и canvas.height, но более длинным

кодом мы продемонстрировали, что холст тоже является частью контекста

(и его не обязательно передавать в другие функции, которые рисуют что-то,

для чего требуется знать параметры холста).

Реакция на мышь

В конце обработчика допишем пару вспомогательных функций и ещё один обработчик.

const drawAt = (x, y) => {

ctx.fillStyle = 'white';

ctx.fillRect(x - 5, y - 5, 11, 11);

};

const getMouseCoords = (data) => {

const { x, y } = canvas.getBoundingClientRect();

const curX = data.clientX - x;

const curY = data.clientY - y;

return [curX, curY];

};

canvas.onmousedown = (data) => {

if (data.button != 0) { return; }

const [x, y] = getMouseCoords(data);

drawAt(x, y);

};

Первая из функций ставит белый квадратик с центром в заданной точке.

Вторая же используется для получения координат указателя мыши по информации, предоставляемой браузером обработчику событий, связанных с мышью (к сожалению, браузер не предоставляет координаты мыши относительно элемента, принявшего событие; поэтому их приходится пересчитывать из глобальных координат).

Теперь мы можем ставить на холст отдельные квадратики.

Рисование линий

Наконец, модифицируем код так, чтобы можно было рисовать непрерывные линии. Первый шаг: добавление переменной, хранящей состояние кнопки мыши (нажата/отжата), и переменных, хранящих предыдущие координаты мыши:

let buttonPressed = false;

let prevX = null;

let prevY = null;

onmousemove = (data) => {

if (!buttonPressed) { return; }

const [curX, curY] = getMouseCoords(data);

/* рисуем линию между prevX,prevY и curX,curY */

prevX = curX;

prevY = curY;

};

canvas.onmousedown = (data) => {

if (data.button != 0) { return; }

buttonPressed = true;

const [x, y] = getMouseCoords(data);

drawAt(x, y);

};

onmouseup = (data) => {

if (data.button != 0) { return; }

buttonPressed = false;

prevX = null;

prevY = null;

};

Предыдущий canvas.onmousedown нужно заменить на вышеприведённый: в нём

есть одна дополнительная строчка buttonPressed = true;.

Отметим, что onmouseup у нас глобальный, а не от холста: мы можем

вывести курсор за предел холста и там отпустить кнопку.

Рисование линии можно реализовать, например, одной из модификаций алгоритма Брезенхема:

if (prevX === null) {

drawAt(curX, curY);

} else {

const dx = curX - prevX;

const dy = curY - prevY;

if (dx === 0 && dy === 0) {

drawAt(curX, curY);

} else if (Math.abs(dy) > Math.abs(dx)) {

for (let i = 0; i <= Math.abs(dy); i++) {

const rx = prevX + dx * i / Math.abs(dy);

const ry = prevY + dy * i / Math.abs(dy);

drawAt(rx, ry);

}

} else if (Math.abs(dx) >= Math.abs(dy)) {

for (let i = 0; i <= Math.abs(dx); i++) {

const rx = prevX + dx * i / Math.abs(dx);

const ry = prevY + dy * i / Math.abs(dx);

drawAt(rx, ry);

}

}

}

Двумерная графика

Для начала мы рассмотрим некоторые математические аспекты и алгоритмы двумерной графики.

А именно, поговорим о:

- том, как моделировать точки и преобразования множеств точек числами

- том, как строить геометрию, с которой удобно общаться программным образом (наборы отрезков/треугольников), по альтернативным представлениям (облака точек и скалярные поля)

Векторы и линейные преобразования

В компьютерной графике мы изображаем какие-то области плоскости/пространства — сущностей, которые присутствуют только у нас в голове (и, с некоторыми оговорками, — вокруг нас). Компьютер же умеет работать только с числами (да и тоже — с большим количеством оговорок).

Соответственно, первостепенная задача — определиться со способом моделирования плоскости/пространства при помощи чисел.

Пока мы будем говорить лишь о плоскости, но все приведённые рассуждения с минимальными изменениями переносятся на случай пространства.

Системы координат

Если мы фиксируем невырожденный треугольник \(ABC\) (слово «невырожденный» означает, что вершины этого треугольника не лежат на одной прямой), то тогда для любой точки \(X\), зная расстояния \(XA\), \(XB\), \(XC\), можно однозначно восстановить её положение:

- точка \(X\) лежит на окружности с центром в \(A\) и радиусом \(XA\)

- эта же точка лежит на окружности с центром в \(B\) и радиусом \(XB\)

- есть не более двух точек пересечения этих окружностей

- эти точки (в том случае, когда их две) находятся на разном расстоянии от точки \(C\), поэтому ровно одна из них находится на расстоянии \(XC\)

Поэтому любую точку можно задать тремя числами — расстояниями до вершин треугольника. К сожалению, этот подход имеет много недостатков. В частности, такие:

- не все тройки чисел соответствуют точкам

- простейшие геометрические объекты (например, прямая и окружность) имеют очень сложные выражения в терминах таких троек чисел

Тем не менее, сам факт о возможности восстановления положения точки по тройке расстояний, очень полезен и неоднократно понадобится нам в дальнейшем.

А сейчас мы предложим другой подход, который обычно и используется. Проведём из точки \(X\) прямые, параллельные \(AC\) и \(AB\). Первая прямая где-то пересекает прямую \(AB\), вторая — \(AC\). Точки пересечения этих прямых с \(AB\) и \(AC\) назовём \(Y\) и \(Z\) соответственно.

Первой координатой точки \(X\) мы назовём отношение \(AY/AB\) если точка \(Y\) лежит по ту же сторону от \(A\), что и \(B\), и \(-AY/AB\) — в противном случае. Аналогично определим вторую координату точки \(X\) (взяв \(C\) вместо \(B\) и \(Z\) вместо \(Y\)).

Таким образом мы сопоставили каждой точке пару чисел. Более того, любая пара чисел оказалась сопоставлена какой-то одной точке. Самое главное, что теперь любая прямая может быть задана линейным неоднородным уравнением: а именно, прямая — это множество всевозможных точек с координатами \(x_1,x_2\), удовлетворяющими уравнению

\[ ax_1 + bx_2 + c = 0 \]

для какой-то тройки \(a, b, c\), в которой кто-то из \(a\) или \(b\) не ноль.

Более того, если выбрать треугольник \(ABC\) так, что \(\angle BAC = 90^\circ\), а \(AB=AC=1\), то появляются ещё две важные формулы:

- расстояние между точками с координатами \((a_1, a_2)\) и \((b_1, b_2)\) равно \(\sqrt{(a_1-b_1)^2 + (a_2-b_2)^2}\)

- окружность с центром в точке \((a_1, a_2)\) и радиусом \(R\) может быть задана уравнением \((x_1-a_1)^2 + (x_2-a_2)^2 = R^2\)

Векторы

Для практических целей точки не являются слишком удобными объектами: хотя над ними и есть некоторое количество полезных и нетрудно описываемых в вышеприведённой модели операций (например, провести прямую через две точки), формулы, использующие лишь координаты точек, быстро становятся слишком сложными, и поэтому хочется чего-то большего.

И это что-то большее есть — векторы. Самая трудная часть векторов — их определение. Вообще говоря, в математике слово «вектор» употребляется в двух смыслах: «широком» и «узком».

В широком смысле вектор — тип объектов, для которых определены операции:

- сложения двух векторов

- растяжения вектора (в некоторое число раз)

Для этих операций требуется некоторый естественный набор свойств (например, растянуть сумму векторов всё равно что растянуть в такое же число раз каждый из векторов, а затем результаты сложить). В программировании такое называется «интерфейсом» или «абстрактным типом данных».

В узком же смысле вектор — это конкретная геометрическая реализация вышеописанного интерфейса. Причём, есть несколько широкораспространённых подходов. Каждый из них опишем на псевдопитоне.

Подход №1: направленный отрезок с нетрадиционным равенством

class Vector:

# модель -- пара точек

def __init__(self, A, B):

self.src = A

self.dst = B

def __eq__(self, other):

# пусть distance считает расстояние между точками:

c1 = distance(self.src, self.dst) == distance(other.src, other.dst)

# пусть same_side(A,B,C,D) определяет, лежат ли C и D по одну

# сторону от прямой AB на плоскости, если A!=B,

# или точки A на прямой AC, если A=B

c2 = same_side(self.src, other.src, self.dst, other.dst)

return (c1 and c2)

def __add__(self, other):

A = self.src

B = self.dst

C = find_sum(B, other) # такая точка, что Vector(B, C) == other

return Vector(A, C)

def scale(self, k):

A = self.src

B = self.dst

C = find_scaled(A, B, k) # такая точка, что AC = |k| AB, причём

# B и C по одну или разные стороны от A

# в зависимости от знака k

return Vector(A, C)

Подход №2: множество направленных отрезков

class Vector:

def __init__(self, A, B):

self.names = {

(X, Y)

for X in plane

for Y in plane

if distance(A, B) == distance(X, Y)

if same_side(A, X, B, Y)

}

def __eq__(self, other):

return self.names == other.names

def __add__(self, other):

for a, b in self.names:

A, B = a, b

break

# пусть extract_wth_src(s, x) выдаёт элемент e множества s,

# которого e[0] == x

_, C = extract_with_src(other.names, B)

return Vector(A, C)

def scale(self, k):

for a, b in self.names:

A, B = a, b

break

C = find_scaled(A, B, k)

return Vector(A, C)

Подход №3: пара чисел

Этот подход предполагает, что у каждой точки есть координаты .x и .y в

некоторой заранее фиксированной системе координат.

class Vector:

def __init__(self, A = None, B = None):

if A == None:

self.x = 0

self.y = 0

else:

self.x = B.x - A.x

self.y = B.y - A.y

def __eq__(self, other):

return self.x == other.x and self.y == other.y

def __add__(self, other):

result = Vector()

result.x = self.x + other.x

result.y = self.y + other.y

return result

def scale(self, k):

result = Vector()

result.x = self.x * k

result.y = self.y * k

return result

Подход №4: «закреплённые» вектора

Этот подход предполагает, что есть заранее фиксированная точка P.

class Vector:

def __init__(self, A, B):

self.dst = find_end(P, A, B)

# такая точка Q, что PQ = AB и выполнено same_side(P, A, Q, B)

def __eq__(self, other):

return self.dst == other.dst

def __add__(self, other):

Q = find_end(self.dst, P, other.dst)

return Vector(P, Q)

def scale(self, k):

Q = find_scaled(P, self.dst, k)

return Vector(P, Q)

Так что же из этого лучше?

Первый подход неудачен как с точки зрения программирования (информация избыточна, реализации методов сложны), так и с точки зрения математики (в которой очень не приветствуются нетрадиционные способы определения равенства, так как равенство обычно является частью логики — того «железа», на котором математика работает).

Второй подход общепринят в математике, но с трудом применим в программировании из-за необходимости общения с бесконечными множествами.

Третий же подход (и некоторые его модификации) используется в программировании.

Четвёртый подход можно встретить как в математике, так и в программировании, хотя он и не очень популярен (особенно в математике, где не очень любят «заранее фиксируем произвольную точку \(P\)»).

В любом из этих подходов направленный отрезок (пара точек) задаёт некоторый вектор, но сам не является вектором. Вектор, соответствующий направленному отрезку \((A,B)\) договоримся обозначать \(\overrightarrow{AB}\).

Небольшое лирическое отступление: разница между вторым и четвёртым подходами ровно та же, что и разница между «назовём рациональным числом максимальное по вложению множество пар целых чисех (второе из которых не равно нулю), в котором любые две пары \(a,b\) и \(x,y\) связаны соотношением \(ay=bx\)» и «назовём рациональным числом пару из целого и целого положительного числа, НОД которых равен 1».

Разложение по базису

Пусть вектора \(e_1, e_2\) соответствуют непараллельным направленным отрезкам. Тогда для любого вектора \(v\) существует единственная пара действительных чисел \(v_1, v_2\), для которой

\[ v = v_1 e_1 + v_2 e_2 \]

Такое представление вектора \(v\) называется разложением по базису \(e_1, e_2\), а сами числа \(v_1\) и \(v_2\) — координатами вектора \(v\) в базисе \(e_1, e_2\).

Не следует путать понятия координат точки и координат вектора. Кроме того, что точки и векторы — объекты разной природы, есть ещё следующие соображения:

- координаты точки требуют наличия системы координат — невырожденного треугольника

- координаты вектора требуют наличия базиса — пары непараллельных векторов

Причём если для любой системы координат \(ABC\) есть традиционный базис, ей соответствующий — вектора \(\overrightarrow{AB}\) и \(\overrightarrow{AC}\) — то ни для какого базиса нет какой-то определённой ассоциированной с ним системы координат.

Движения и некоторые другие преобразования

Напомним, что движением называется отображение плоскости в себя (т.е. функция, принимающая на вход точку плоскости и возвращающая точку плоскости), сохраняющее расстояния между парами точек.

Говоря псевдокодом, это такая функция f, что для любых точек A и B

выполнено

distance(f(A), f(B)) == distance(A, B)

Зададимся вопросом о том, как можно задать движение \(f\) плоскости при помощи набора чисел.

Фиксируем некоторый треугольник \(ABC\) и обозначим \(e_1 = \overrightarrow{AB}\) и \(e_2 = \overrightarrow{AC}\).

Введём также обозначения \(X=f(A)\), \(Y=f(B)\), \(Z=f(C)\), \(f_1 = \overrightarrow{XY}\) и \(f_2 = \overrightarrow{XZ}\).

Рассмотрим точку \(P\) с координатами \(p_1, p_2\) в системе координат \(ABC\). Это можно записать в терминах векторов так:

\[ \overrightarrow{AP} = p_1 e_1 + p_2 e_2 \]

Поскольку движение \(f\) не меняет расстояния между точками, расстояния от \(f(P)\) до \(X, Y, Z\) равны соответственно расстояниям от \(P\) до \(A, B, C\). А ещё они же равны расстояниям до \(X, Y, Z\) от точки \(Q\), определённой равенством

\[ \overrightarrow{XQ} = p_1 f_1 + p_2 f_2 \]

Вспомнив о том, что тройка расстояний однозначно задаёт точку, получаем, что \(f(P) = Q\).

Заметив равенство \(\overrightarrow{AQ} = \overrightarrow{AX} + \overrightarrow{XQ}\), получаем, что для того, чтобы узнать координаты вектора \(\overrightarrow{AQ}\) в базисе \(e1, e2\) (они же — координаты точки \(Q\) в системе координат \(ABC\)), достаточно знать координаты векторов \(\overrightarrow{AX}\) и \(\overrightarrow{XQ}\) в этом же базисе.

Разложим \(f_1\), \(f_2\) и \(\overrightarrow{AX}\) по базису \(e1, e2\):

\[ \begin{aligned} f_1 & = f_{11} e_1 + f_{12} e_2 \\ f_2 & = f_{21} e_1 + f_{22} e_2 \\ \overrightarrow{AX} & = x_1 e_1 + x_2 e_2 \end{aligned} \]

Подставив эти разложения в выражение для \(\overrightarrow{AQ}\), получим

\[ \begin{aligned} \overrightarrow{AQ} & = (p_1 f_{11} + p_2 f_{21} + x_1)e_1 \\ & + (p_1 f_{12} + p_2 f_{22} + x_2)e_2 \end{aligned} \]

Набор чисел

\[ M = \begin{pmatrix} f_{11} & f_{21} & x_1 \\ f_{12} & f_{22} & x_2 \end{pmatrix} \]

называется матрицей преобразования \(f\). Такими матрицами при помощи вышеприведённой формулы можно задавать не только движения, но и другие преобразования (растяжения и скосы). Класс преобразований, задающихся формулой

\[ \begin{aligned} \overrightarrow{AQ} & = (p_1 f_{11} + p_2 f_{21} + x_1)e_1 \\ & + (p_1 f_{12} + p_2 f_{22} + x_2)e_2 \end{aligned} \]

называется линейными неоднородными преобразованиями.

Поэкспериментировать с ними можно в демонстрации.

Напоследок скажем, что, к сожалению, нет устоявшегося соглашения о том, как именно следует ставить эти 6 чисел в таблицу. Единственное более-менее общепринятое соглашение — о нумерации строк и столбцов таблицы:

\[ M = \begin{pmatrix} M_{11} & M_{12} & M_{13} \\ M_{21} & M_{22} & M_{23} \end{pmatrix} \]

То есть, в наших обозначениях \(M_{11} = f_{11}\), \(M_{12} = f_{21}\), \(M_{13} = x_{1}\), \(M_{21} = f_{12}\), \(M_{22} = f_{22}\), \(M_{23} = x_{2}\).

Приложение А (о понятии линейности)

Вообще говоря, в математике есть «широкое» понятие линейного преобразования. Так называется преобразование \(f\) векторных простанств, т.е. преобразующее вектор в вектор (возможно, другой природы), удовлетворяющее равенству

\[ f(\alpha u + \beta v) = \alpha f(u) + \beta f(v) \]

для любой пары чисел \(\alpha,\beta\) и пары векторов \(u\) и \(v\).

Нетрудно заметить, что преобразование, преобразующее вектор \(v = v_1 e_1 + v_2 e_2\) по формулам

\[ \begin{aligned} f(v) & = (v_1 f_{11} + v_2 f_{21})e_1 \\ & + (v_1 f_{12} + v_2 f_{22})e_2 \end{aligned} \]

является линейным.

Более того, любое линейное преобразование (векторов плоскости) можно задать такой формулой: поскольку для всех \(v_1\) и \(v_2\) выполнено

\[ f(v_1 e_1 + v_2 e_2) = v_1 f(e_1) + v_2 f(e_2) \]

то, зная \(f(e_1)\) и \f(e_2)\), мы знаем, во что преобразуется любой вектор. Соответственно, числа \(f_{ij}\) из вышеприведённой формулы для \(f(v)\) получаются путём разложения \(f(e_i)\) по базису:

\[ \begin{aligned} f(e_1) & = f_{11} e_1 + f_{12} e_2 \\ f(e_2) & = f_{21} e_1 + f_{22} e_2 \end{aligned} \]

Теперь, наконец, заметим что линейные преобразования векторов (ЛПВ) — это совсем не то же самое, что и рассмотренные нами выше линейные неоднородные преобразования плоскости (ЛНПП):

- ЛПВ преобразуют вектора в вектора, ЛНПП — точки плоскости — в точки плоскости

- даже если отоджествить точки плоскости с их радиус-векторами (относительно некоторого «начала»), ЛПВ не позволяют моделировать сдвиги

Приложение Б (о проективной геометрии)

В том случае, когда уж очень хочется оставаться в рамках линейных преобразований векторов (например, по той причине, что про них есть такая огромная область математики как линейная алгебра), можно воспользоваться следующим трюком:

- увеличить размерность пространства на 1 (т.е. рассмотреть вместо плоскости трёхмерное пространство)

- выбрать в нём плоскость \(\pi\) и точку \(P\), не лежащую в ней

- на множестве всех векторов ввести операцию «проекции»:

- если вектор \(v\) параллелен \(\pi\), то сопоставим ему вектор плоскости \(\pi\), соответствующий направленному отрезку, лежащему в \(pi\) и задающему \(v\) в пространстве

- если же вектор \(v\) не параллелен \(\pi\), то сопоставим ему точку пересечения прямой, проведённой из \(P\) и параллельной \(v\), с плоскостью \(\pi\)

- при этом обычно выбирают систему координат \(PABC\), в которой \(PA\), \(PB\) и \(PC\) равны по длине и перпендикулярны друг другу, причём \(C\) находится в плоскости \(\pi\)

- при таком выборе проекция векторов, не параллельных \(\pi\) — просто отображение вида \((x,y,z)\mapsto (x/z, y/z, 1)\)

У этого подхода очень много привлекательных сторон:

- теперь сдвиги — тоже линейные преобразования (трёхмерных) векторов

- можно моделировать как точки, так и вектора плоскости тройками чисел без вероятности их перепутать: у векторов третья координата 0, у точек же она ненулевая

- если для всех точек определить канонические координаты как те, у которых третья компонента равна 1, то получим удобные соотношения вида «разность точек является вектором» и «сумма точки и вектора является точкой»

Но есть и недостатки:

- теперь у одной и той же точки есть бесконечно много троек чисел, ей соответствующих

- три числа больше, чем два (и менее эффективно с вычислительной точки зрения)

- нет единого соглашения о том, отличать ли точки с отрицательной третьей

координатой от таковых с положительной:

- математики предпочитают считать, что отличать не нужно (более того, они отождествляют даже параллельные \(\pi\) вектора, если эти вектора параллельны друг другу, а нулевой вектор вообще выкидывают)

- программисты же чаще различают такие точки, чем нет (и по факту работают не с «проективной плоскостью» в общематематическом смысле, а просто — с парой или тройкой обычных плоскостей)

В заключение отметим, что та матрица \(3\times 3\), которая изображена на MDN в документации к методу setTransform

\[ \begin{pmatrix} f_{11} & f_{21} & x_1 \\ f_{12} & f_{22} & x_2 \\ 0 & 0 & 1 \end{pmatrix} \]

это — именно матрица линейного преобразования проективной геометрии. И применяется она к вектору \(p_1 e_1 + p_2 e_2 + 1 e_3\), который соответствует точке плоскости с координатами \((p_1, p_2)\).

Облака точек

В процессе написания

Его нужно дописать до чего-нибудь интересного.

Он уже дописан до чего-то интересного.

Если у кого-то есть вопросы о том, что там происходит, то пока тезисно:

- рисуем границу «облака точек»

- для этого каждую из точек облака «штампуем» на квадратную сетку

- форма «кисти» называется функцией влияния

- у нас влияние радиально (убывает в зависимости от расстояния до точки)

- после того, как мы учли влияние всех точек облака на сетку, про облако забываем

- те узлы сетки, в которых влияние достаточно большое, считаем находящимися внутри облака

- остальные узлы считаем находящимися снаружи

- для каждой клетки сетки в зависимости от того, какие её узлы находятся внутри облака, а какие — снаружи (всего 16 случаев), строим отрезки границы

Именно последний пункт называется марширующими квадратами, и как раз он (а точнее, его цикл по всем клеткам сетки) отсутствует в коде по ссылке (также там отсутствует значительная часть таблицы, показывающей, какие стороны клетки нужно соединять отрезками в каком из случаев).

Трёхмерная графика

Этот раздел — основная часть курса. Поэтому без лишних слов предлагаем просто перейти к первому его подразделу.

Геометрическая алгебра

Здесь речь пойдёт о геометрической алгебре — науке, изучающей алгебраические свойства некоторых геометрических объектов.

Не следует путать геометрическую алгебру с гораздо более сложной и абстрактной алгебраической геометрией — наукой, изучающей геометрические свойства некоторых алгебраических объектов.

Произведения в алгебре

Основные операции в алгебре — сумма и произведение. Какие бы действия этими словами не назывались, обычно от них требуют выполнения распределительных законов:

\[ \begin{aligned} a(x+y) & = ax + ay \\ (a+b)x & = ax + bx \end{aligned} \]

Почти никаких других свойств обычно не требуют, но некоторые прилагаются к распределительным законам более-менее забесплатно.

Например, если есть «единица» — такой объект \(e\), что

\[ ae = ea = a \]

то, если сложение обладает сочетательным законом, выполняется равенство

\[ x + x + y + y = x(e+e) + y(e+e) = (x+y)(e+e) = (x+y)e + (x+y)e = x + y + x + y \]

откуда при возможности сокращения на \(x+\square\) и \(\square+y\) следует переместительный закон сложения:

\[ x + y = y + x \]

Как мы уже знаем, в геометрии широко используются векторы, которые можно складывать между собой и растягивать в числовой коэффициент раз.

А вот о произведении векторов между собой не говорят. Причём по очень простой причине: разных способов ввести осмысленное произведение существует очень много, причём все они обладают билинейностью — расширенной версией распределительных законов: а именно, для любых чисел \(\alpha\) и \(\beta\) выполнено

\begin{aligned} a(\alpha x + \beta y) & = \alpha ax + \beta ay \\ (\alpha a + \beta b)x & = \alpha ax + \beta bx \end{aligned}

Наиболее полезные из произведений мы и рассмотрим в этом разделе. Договоримся при этом, что у нас заранее фиксирован некоторый ортонормированный базис \(e_1\), \(e_2\), \(e_3\). Ортонормированность означает, что вектора перпендикулярны друг другу и все они единичной длины.

Таблица умножения

Заметим, что из билинейности следует, что произведение любой пары векторов можно однозначно задать, задав произведения базисных:

\[ (a_1e_1 + a_2e_2 + a_3e_3)(b_1e_1 + b_2e_2 + b_3e_3) = \sum_{ij} (a_ia_j)(e_ie_j) \]

Зная \(e_ie_j\), мы можем по этой формуле вычислить произведение любой пары векторов.

Скалярное произведение

Обычно обозначается точкой. Результат — число. Имеет следующую таблицу умножения:

\[ \begin{matrix} e_1\cdot e_1 = 1 & e_1\cdot e_2 = 0 & e_1\cdot e_3 = 0 \\ e_2\cdot e_1 = 0 & e_2\cdot e_2 = 1 & e_2\cdot e_3 = 0 \\ e_3\cdot e_1 = 0 & e_3\cdot e_2 = 0 & e_3\cdot e_3 = 1 \end{matrix} \]

Из этой таблицы следует общая формула

\[ (a_1e_1 + a_2e_2 + a_3e_3)\cdot(b_1e_1 + b_2e_2 + b_3e_3) = a_1b_1 + a_2b_2 + a_3b_3 \]

В частности, если \(a_i = b_i\), получается сумма квадратов координат вектора, что, согласно теореме Пифагора, является длиной этого вектора. Поэтому сформулируем

Свойство №1: скалярный квадрат есть квадрат длины

\[ a\cdot a = |a|^2 \]

Далее заметим, что из явной формулы сразу следует

Свойство №2: скалярное произведение коммутативно

\[ a\cdot b = b\cdot a \]

Пусть теперь вектора \(a\) и \(b\) перпендикулярны друг другу. Тогда

\[ (a+b)\cdot(a+b) = |a+b|^2 = \text{по т. Пифагора} = |a|^2 + |b|^2 = a\cdot a + b\cdot b \]

Если мы теперь раскроем скобки в левой части и сократим обе части на \(a\cdot a\) и \(b\cdot b\), то останется

\[ a\cdot b + b\cdot a = 0 \]

А из того, что \(a\cdot b = b\cdot a\), сразу следует

Свойство №3: скалярное произведение перпендикулярных векторов равно нулю

\[ a\cdot b = 0,\;\text{если \(a\) и \(b\) перпендикулярны} \]

Пусть теперь \(a\) и \(b\) — два произвольных вектора, причём \(b\) ненулевой. Обозначим \(A\) проекцию вектора \(a\) на вектор \(b\). Заметим, что тогда вектор

\[ c = a - \frac{A}{|b|}b \]

перпендикулярен вектору \(b\). Поэтому \(c\cdot b = 0\). Раскрывая в этом равенстве \(c\) по определению, получаем

\[ a\cdot b - \frac{a}{|b|}|b|^2 = 0 \]

откуда следует

Свойство №4: скалярное произведение векторов равно произведению проекции одного из них на другой и длины другого

что, с учётом \(A=|a|\cos\angle(a,b)\) можно записать как

\[ a\cdot b = |a||b|\cos\angle(a,b) \]

откуда следует

Свойство №5: если скалярное произведение ненулевых векторов равно нулю, то они перпендикулярны

Каких свойств нет?

Нет, к сожалению, сочетательного закона: результат — число, которое нельзя скалярно умножить на вектор.

Более того, если даже скалярным произведением числа на вектор считать растяжение, сочетательного закона всё равно нет:

\[ e_2 = (e_1\cdot e_1) e_2 \ne e_1 (e_1\cdot e_2) = 0 e_1 \]

Векторное произведение

Обычно обозначается крестиком. Результат — вектор.

Имеет следующую таблицу умножения:

\[ \begin{matrix} e_1\times e_1 = 0 & e_1\times e_2 = e_3 & e_1\times e_3 = -e_2 \\ e_2\times e_1 = -e_3 & e_2\times e_2 = 0 & e_2\times e_3 = e_1 \\ e_3\times e_1 = e_2 & e_3\times e_2 = -e_1 & e_3\times e_3 = 0 \end{matrix} \]

Из этой таблицы следует общая формула

\[ \begin{aligned} (a_1e_1 + a_2e_2 + a_3e_3)\times(b_1e_1 + b_2e_2 + b_3e_3) & = e_1 (a_2b_3 - a_3b_2) \\ & + e_2 (a_3b_1 - a_1b_3) \\ & + e_3 (a_1b_2 - a_2b_1) \end{aligned} \]

Из этой формулы сразу следует

Свойство №1: векторный квадрат любого вектора нулевой

\[ a\times a = 0 \]

Более того, из \(a\times b = 0\) следует, что \(a\) и \(b\) параллельны.

Также из общей формулы сразу следует

Свойство №2: векторное произведение антикоммутативно

\[ a\times b = -b\times a \]

А ещё путём нехитрых вычислений из общей формулы можно получить

Свойство №3: векторное произведение перпендикулярно любому из сомножителей

\[ \begin{aligned} (a\times b) \cdot a & = 0 \\ (a\times b) \cdot b & = 0 \end{aligned} \]

Любители алгебры также могут, вычислив скалярный квадрат векторного произведения, без особого труда доказать

Свойство №4: длина векторного произведения перпендикулярных векторов равна произведению их длин

\[ |a\times b| = |a||b|,\;\text{если \(a\) и \(b\) перпендикулярны} \]

Применив это соображение к вектору \(c\) построенному по паре произвольных \(a\) и \(b\) по рецепту из разговора про скалярное произведение, получим

\[ |a\times b| = |c\times b| = |c||b| \]

что с учётом очевидного соотношения \(|c|=|a|\sin\angle(a,b)\) даёт

Свойство №5: длина векторного произведения равна произведению длин векторов, помноженному на синус угла между ними

\[ |a\times b| = |a||b|\sin\angle(a, b) \]

Каких свойств нет

Нет, к сожалению, сочетательного закона, хотя теперь с типами всё нормально. Вместо него есть тождество Якоби:

\[ (a\times b)\times c + (b\times c)\times a + (c\times a)\times b = 0 \]

Тензорное произведение

Вводится исходя из позиции: «нам нужен сочетательный закон, поэтому к чёрту все остальные свойства!»

Для любой последовательности \(\alpha\) чисел из набора от 1 до 3 введём «базисный» тензор \(e_{\alpha}\) (сюда, конечно же, входят наши \(e_1\), \(e_2\), \(e_3\)). Рангом такого тензора будем называть длину последовательности индексов. Например, базисные вектора — тензоры ранга 1.

(Градуированным) тензором будем называть взвешенную сумму таких базисных тензоров (две суммы равны тогда и только тогда, когда равны результаты «приведения подобных»).

Таблица умножения содержит бесконечное множество ячеек вида

\[ e_{\alpha}\otimes e_{\beta} = e_{\alpha\beta} \]

Например,

\[ (1e + 2e_2)\otimes(3e_{23}+4e_{2}) = 3e_{23} + 6e_{223} + 4e_{2} + 8 e_{22} \]

Какие свойства есть?

Есть сочетательный закон

\[ (a\otimes b)\otimes c = a\otimes(b\otimes c) \]

Никуда не делась билинейность (при помощи которой мы определяем произведение произвольных взвешенных сумм базисных тензоров).

Каких свойств нет?

Да никаких интересных, кроме сочетательного закона и билинейности. Также нет никакого геометрического смысла (а что могла бы означать сумма \(3e + 2e_{1} - 7 e_{1332121}\)?)

Полезное соглашение

Как в многочленах никто без надобности не пишет \(ax^0\), так и в тензорах вместо \(ae\), где \(a\) — число, все обычно пишут просто \(a\).

Геометрическое произведение

Обозначается либо никак, либо знаком ⟑. Мы будем обозначать геометрическое произведение никак.

Для того, чтобы ввести геометрическое произведение, нам понадобится понятие строго упорядоченного базисного тензора (СУБТ). Назовём СУБТ базисный тензор, у которого последовательность индексов строго упорядочена.

В трёхмерном пространстве есть всего 8 СУБТ:

- один — ранга 0: \(e\)

- три — ранга 1: \(e_1\), \(e_2\), \(e_3\)

- три — ранга 2: \(e_{12}\), \(e_{13}\), \(e_{23}\)

- один — ранга 3: \(e_{123}\)

Входы: взвешенные суммы СУБТ. Результат: тензор, который тоже является взвешенной суммой СУБТ.

Можно было бы выписать всю таблицу умножения, но мы вместо этого сформулируем процедуру вычисления произведения \(e_{\alpha}e_{\beta}\):

- сортируем последовательность \(\alpha\beta\) путём обменов

- считаем чётность количество обменов

- выкидываем из неё все пары одинаковых чисел; то, что осталось, назовём \(\gamma\)

- если обменов было чётное число, то результат \(e_{\gamma}\)

- если же обменов было нечётное число, то результат \(-e_{\gamma}\)

Например, \(e_{12}e_{13}\) можно вычислить так:

- отсортированная последовательность \(1123\)

- пузырёк делает ровно один обмен; это — нечётное число

- \(\gamma = 23\)

- результат: \(-e_{23}\)

Конечно, открытым остаётся вопрос о том, почему чётность количества обменов не зависит от способа сортировки. Тем не менее, ответ на этот вопрос прост: каждый обмен изменяет чётность количества пар элементов, стоящих в неправильном порядке — таких пар, в которых правый элемент меньше левого.

Свойство №1: сочетательный закон

Как ни странно, но вышеописанная процедура умножения СУБТ ассоциативна. Поэтому и для произвольных сумм СУБТ выполнено

\[ (ab)c = a(bc) \]

Вариации

То, что мы описали выше, называется \((3,0,0)\)-произведением. В общем случае \((a,b,c)\)-произведение определяется в \((a+b+c)\)-мерном пространстве такой же процедурой за исключением шага с удалением дубликатов:

- за каждый дубликат чисел от \(a+1\) до \(a+b\) нужно результат домножить на \(-1\)

- если есть хотя бы один дубликат числа от \(a+b+1\) до \(a+b+c\), то результат равен 0

Независимо от типа, любое такое произведение обладает сочетательным законом.

Произведения типа \((3,1,0)\) используются в теории относительности, а типа \((3,0,1)\) — в проективной геометрической алгебре. Нам же сейчас понадобится \((0,0,3)\)-произведение.

Внешнее произведение

Это самое \((0,0,3)\)-произведение называется внешним и обозначается \(\wedge\).

Нетрудно получить явную формулу для внешнего произведения векторов:

\[ \begin{aligned} (a_1e_1 + a_2e_2 + a_3e_3)\wedge(b_1e_1 + b_2e_2 + b_3e_3) & = e_{12} (a_1b_2 - a_2b_1) \\ & + e_{13} (a_1b_3 - a_3b_1) \\ & + e_{23} (a_2b_3 - a_3b_2) \end{aligned} \]

Не правда ли, похожа на таковую для векторного произведения? Причём внешнее произведение, в отличие от векторного, имеет сочетательный закон!

Из этой формулы сразу следуют

Свойство №2: внешнее произведение вектора с самим собой равно 0

\[ a\wedge a = 0 \]

Более того, из \(a\wedge b = 0\) следует, что вектора \(a\) и \(b\) параллельны.

Это позволяет сразу договориться о геометрическом смысле внешнего произведения.

Поскольку

\[ a\wedge b = (a + tb)\wedge b \]

для любого числа \(t\), а подобными преобразованиями из пары непараллельных векторов можно сделать пару непараллельных векторов любых направлений (где под «направлением» понимается прямая, а не луч), можно заключить следующее: если пара векторов \(a, b\) задаёт ту же плоскость, что и пара векторов \(u, v\), то произведения \(a\wedge b\) и \(u\wedge v\) пропорциональны друг другу.

Более того, если пары векторов \(a, b\) и \(u, v\) задают разные плоскости, то произведения \(a\wedge b\) и \(u\wedge v\) не пропорциональны. Действительно, из этих пар векторов преобразованиями вышеуказанного вида сделать пары, в которых первые вектора параллельны друг другу. Пусть эти пары \(p, q\) и \(\alpha p, r\). Нетрудно заметить, что если бы произведения были бы пропорциональны:

\[ p \wedge q = \beta (\alpha p \wedge r) \]

то их разность, имеющая вид

\[ p \wedge (q - \alpha\beta r) \]

была бы нулевой. А это означало бы, что \(q - \alpha\beta r\) пропорционально \(p\). То есть \(q\) лежало бы в той же плоскости, что и \(p\) с \(r\). Что противоречит предположению о том, что пары \(a,b\) и \(u,v\) задают разные плоскости.

Итого имеем

Геометрический смысл внешнего произведения векторов: это (с точностью до пропорциональности) — плоскость, в которой лежат сомножители

Более того, любая взвешенная сумма СУБТ второго ранга является внешним произведением пары векторов. Действительно, если рассмотреть ненулевую сумму

\[ x_{12} e_{12} + x_{13} e_{13} + x_{23} e_{23} \]

то ей пропорционально внешнее произведение любой пары из следующих векторов:

- \(x_{13} e_1 + x_{23} e_2\)

- \(x_{23} e_3 - x_{12} e_1\)

- \(x_{13} e_3 + x_{12} e_2\)

два из которых заведомо ненулевые.

Свойство №3: внешнее произведение пары векторов антикоммутативно

\[ a\wedge b = -b\wedge a \]

Тут следует быть внимательным: для невекторов это неверно. Как нетрудно заметить, \(e_{12}\wedge e_{3} = e_{123} = e_{3}\wedge e_{12}\), поскольку последовательность \(312\) сортируется двумя обменами.

Наконец, главное свойство геометрической алгебры (следует из явных формул для геометрического и внешнего произведений)

Свойство №4: геометрическое произведение пары векторов есть сумма их скалярного и внешнего произведений

\[ ab = a\cdot b + a\wedge b \]

В частности, если \(a\) и \(b\) перпендикулярны, то их геометрическое произведение совпадает со внешним.

Свойство №5: геометрическое произведение вектора с самим собой есть квадрат его длины

\[ a^2 = |a|^2 \]

Вращения плоскости и пространства

Пусть \(a\) и \(b\) — ортонормированные вектора. Заметим следующую пару соотношений:

\[ \begin{aligned} a(ab) & = aab = b \\ b(ab) & = bab = -abb = -a \end{aligned} \]

То есть умножение на \(ab\) справа поворачивает вектора \(a\) и \(b\) (и, как следствие, — любой вектор плоскости, в которой лежат \(a\) и \(b\)) на прямой угол по направлению от \(a\) к \(b\).

Поскольку поворот на угол \(\alpha\) можно скомбинировать из тождественного преобразования и поворота на прямой угол, получаем

Формулу №1: поворот векторов плоскости

Отображение

\[ v \mapsto v(\cos\alpha + ab\sin\alpha) \]

поворачивает вектор \(v\), лежащий в плоскости ортонормированной пары \(a, b\), на угол \(\alpha\) по направлению от \(a\) к \(b\).

Если нам нужно соединить два поворота, то достаточно перемножить

\[ (\cos\alpha + ab\sin\alpha)(\cos\beta + ab\sin\beta) \]

Что интересно, такое произведение — наиболее простой способ запомнить (или доказать) формулы косинуса и синуса суммы углов.

Лирическое отступление: алгебра, порождённая действительными числами и СУБТ \(e_{12}\) (или же любым другим произведением ортонормированной пары векторов) называется комплексными числами и известна примерно со середины 16 века благодаря работам Джероламо Кардано (благодаря ему же нам известны многочисленные применения карданного вала и карданного подвеса, а также — метод решения кубических уравнений). Несколько позже комплексные числа начали использовать для удобного описания вращений плоскости.

Заметив, что умножение справа на \(ab\) воздействует на вектора плоскости так же, как и умножение слева на \(ba\), мы можем получить

Формулу №2: поворот векторов плоскости

Отображение

\[ v \mapsto (\cos\alpha - ab\sin\alpha)v \]

поворачивает вектор \(v\), лежащий в плоскости ортонормированной пары \(a, b\), на угол \(\alpha\) по направлению от \(a\) к \(b\).

Более того, скомбинировав эти два преобразования, можно получить преобразование, которое не изменяет вектора, перпендикулярные плоскости.

А именно, если \(c\) перпендикулярен как \(a\), так и \(b\), то

\[ \begin{aligned} & (\cos\alpha - ab\sin\alpha)c(\cos\alpha + ab\sin\alpha) \\ =\; & c((\cos\alpha)^2 + (\sin\alpha)^2) + abc(\cos\alpha\sin\alpha-\sin\alpha\cos\alpha) \\ =\; & 1c + 0abc \\ =\; & c \end{aligned} \]

Как следствие, имеем

Формулу №3: поворот векторов пространства

Отображение

\[ v \mapsto (\cos(\alpha/2) - ab\sin(\alpha/2))v(\cos(\alpha/2) + ab\sin(\alpha/2)) \]

поворачивает произвольный вектор \(v\) на угол \(\alpha\) по направлению от \(a\) к \(b\).

Конечно, хочется иметь возможность задавать поворот не плоскостью и уголом, а осью и углом. Но это, оказывается, несложно.

А именно, если мы произведём замену

\[ \begin{aligned} e_1 & \mapsto e_2e_3 \\ e_2 & \mapsto e_3e_1 \\ e_3 & \mapsto e_1e_2 \end{aligned} \]

то получим из вектора перпендикулярную ему плоскость (точнее, тензор, являющийся произведением пары векторов, в этой плоскости лежащих).

Чтобы это понять, можно провести следующее рассуждение: рассмотрим тройку ортонормированных векторов \(a,b,c\). Вычислим произведение

\[ (Aa + Bb + Cc)ab \]

где \(A,B,C\) — произвольные числа.

Получим следующее:

\[ Ab - Ba + Cabc \]

Как нетрудно видеть, тензоры первого ранга в таком произведении присутствуют тогда и только тогда, когда вектор не перпендикулярен плоскости.

Осталось вычислить

\[ (x_1 e_1 + x_2 e_2 + x_3 e_3)(x_1 e_2e_3 + x_2 e_3e_1 + x_3e_1e_2) \]

и заметить, что все тензоры первого ранга в итоговой сумме взаимоуничтожатся.

Конечно, остаётся вопрос: при каком условии сумма вида \(x_1 e_2e_3 + x_{2} e_3e_1 + x_{3} e_1e_2\) может быть представлена в виде произведения пары ортонормированных векторов?

Мы дадим ответ: тогда и только тогда, когда \(x^2_1 + x^2_2 + x^2_3 = 1\). А доказательство оставим в качестве тривиального упражнения, напомнив лишь, что:

- любая сумма СУБТ второго ранга представляется в виде внешнего произведения векторов

- внешнее произведение перпендикулярных векторов совпадает с их геометрическим произведением

- если \(a\) и \(b\) перпендикулярны, то \((ab)(ab) = -aabb = -|a|^2 |b|^2\)

Опять лирическое отступление: алгебра, порождённая действительными числами и тензорами \(e_{12}\), \(e_{13}\) и \(e_{23}\), называется алгеброй кватернионов. До развития методов геометрической алгебры именно кватернионы применялись для удобного описания вращений пространства. С кватернионами мы ещё встретимся далее.

Некоторые практические задачи

Решение линейных уравнений

Начнём с одной из важнейших задач — решения линейных уравнений.

Допустим, нам известно, что \(ax = b\), и нужно найти \(x\).

В некоторых случаях подобная задача хорошо решается:

- если \(a\) — ненулевой вектор, то \(|a|^2x = ab\), откуда \(x = ab / |a|^2\)

- если \(a = \alpha + v\), где \(\alpha\) — число, а \(v\) — вектор, то \((\alpha-v)(\alpha + v) = \alpha^2 - |v|^2\); если эта разность отлична от нуля, то \(x = (\alpha-v)b / (\alpha^2 - |v|^2)\)

- аналогично, если \(a = \alpha + t\), где \(t\) — тензор второго ранга, то \(x = (\alpha - t)b / (\alpha^2 + |t|^2)\), где \(|t|^2\) — обозначение для суммы квадратов компонент тензора \(t\) в базисе \(e_{12}\), \(e_{13}\), \(e_{23}\)

Вычисление угла между векторами

Допустим, что \(a\) и \(b\) — вектора, и нам известно их геометрическое произведение \(ab\).

Поскольку \(ab = a\cdot b + a\land b\), то \(ba = a\cdot b - a\land b\) и, зная \(ab\) мы можем вычислить \(ba\) просто поменяв знак во всех компонентах второго ранга.

Это означает, что мы можем вычислить \(|a|^2|b|^2 = (ba)(ab)\).

А, зная произведение длин векторов, мы легко можем узнать косинус угла между ними: он равен \(a\cdot b / |a||b|\).

Простейшая программа

В этом разделе мы воспользуемся OpenGL и геометрической алгеброй для реализации вращающегося куба.

WebGL-контекст

До этого мы использовали контекст 2d, который давал доступ к некоторым

относительно высокоуровневым примитивам. Сейчас мы будем использовать

контекст webgl2, который даёт доступ к функциям OpenGL.

let GL = null;

onload = () => {

...

const canvas = document.getElementById(`идентификатор`);

canvas.width = 600;

canvas.height = 600;

GL = canvas.getContext(`webgl2`);

...

}

В данном случае мы для простоты привязали контекст к глобальной переменной.

Но следует помнить о том, что использование локальной переменной для контекста помогает отделить те функции, которые занимаются непосредственно взаимодействием с видеокартой, от тех, которые этим не занимаются.

Минимальная анимация

Чтобы убедиться, что всё работает, в конец инициализации добавим

const renderFrame = time => {

GL.clearColor((1 + Math.cos(time/1000))/2, 0, 0, 1);

GL.clear(GL.COLOR_BUFFER_BIT | GL.DEPTH_BUFFER_BIT);

requestAnimationFrame(renderFrame);

};

requestAnimationFrame(renderFrame);

Функция браузера requestAnimationFrame получает на вход функцию и

откладывает её выполнение до того момента, как браузер не будет готов

нарисовать очередной кадр (обычно браузер рисует кадры с частотой

около 60 кадров в секунду).

В тот момент, когда браузер будет готов, отложенная функция будет вызвана, а её на вход подано время, прошедшее с момента запуска программы (выраженное в милисекундах).

Куб

Сначала сформируем данные для рисования куба в оперативной памяти компьютера. Договоримся, что каждая вершина будет задаваться тройкой координат и её номером (от которого будет зависеть её цвет).

function makeCube() {

const v0 = [-1, -1, -1, 0];

const v1 = [-1, -1, 1, 1];

const v2 = [-1, 1, -1, 2];

const v3 = [-1, 1, 1, 3];

const v4 = [1, -1, -1, 4];

const v5 = [1, -1, 1, 5];

const v6 = [1, 1, -1, 6];

const v7 = [1, 1, 1, 7];

return Float32Array.from(

v0.concat(v1).concat(v2)

.concat(v1).concat(v2).concat(v3)

.concat(v0).concat(v1).concat(v4)

.concat(v1).concat(v4).concat(v5)

.concat(v0).concat(v2).concat(v4)

.concat(v2).concat(v4).concat(v6)

.concat(v7).concat(v3).concat(v6)

.concat(v3).concat(v6).concat(v2)

.concat(v7).concat(v5).concat(v3)

.concat(v5).concat(v3).concat(v1)

.concat(v7).concat(v5).concat(v6)

.concat(v5).concat(v6).concat(v4)

);

}

Эта функция выдаёт типизированный массив (все его числа хранятся в памяти в стандартном формате одинарной точности). Именно такой массив затем можно записать в память видеокарты.

Для того, чтобы переписать эти данные в память видеокарты, можно воспользоваться следующим кодом:

const buffer = GL.createBuffer();

GL.bindBuffer(GL.ARRAY_BUFFER, buffer);

GL.bufferData(GL.ARRAY_BUFFER, makeCube(), GL.STATIC_DRAW);

Метод createBuffer создаёт (изначально пустой) массив в памяти видеокарты

и возвращает его уникальный идентификатор,

а bufferData выделяет память и копирует данные из оперативной памяти

компьютера в видеопамять.

Метод bindBuffer — некоторый анахронизм: по какой-то причине

bufferData, вместо того, чтобы принимать на вход уникальный идентификатор

буфера, принимает на вход специальную константу — текущее назначение

буфера. Соответствующий буфер должен при этом быть заранее привязан к

этому назначению.

Далее мы ещё встретим несколько функций, которые работают именно с тем

буфером, который последним был связан с назначением ARRAY_BUFFER.

Замечание На самом деле, createBuffer всего лишь ищет и

возвращает неиспользованный идентификатор, а буфер создаётся во время

вызова bindBuffer. Но WebGL этот факт от пользователя тщательно

скрывает (и правильно делает). Тем не менее, если об этом помнить,

то не будет соблазна один и тот же буфер привязывать при помощи

bindBuffer к разным назначениям.

Вершинная и фрагментная программы

Несколько упрощённо процедуру работы видеокарты можно описать следующим образом. Для того, чтобы нарисовать треугольник, она:

- для каждой вершины треугольника забирает из видеопамяти какой-то набор чисел, называемых атрибутами

- к этим атрибутам применяет программу, называемую термином вершинный шейдер

- вершинный шейдер выдаёт положение вершины в пространстве и некоторый набор выходных атрибутов

- по положениям вершин вычисляется положение треугольника на экране, к каждому пикселю этого треугольника применяет фрагментный шейдер

- фрагментному шейдеру доступны выходные атрибуты вершинного, линейно инетрполированные из соответствующей тройки вершин (под линейной интерполяцией понимается взвешенная сумма значений, веса в которой — доли, которые составляют площади треугольников, две стороны каждого из которых проведены от рассматриваемого пикселя к вершинам, противоположным той, про вес чьего значения сейчас идёт речь, по отношению к площади треугольника, образованного всей тройкой вершин)

- фрагментный шейдер выдаёт цвет пикселя (и его глубину — если она оказывается больше, чем последняя выданная этому пикселю глубина, пиксель не рисуется)

Сперва зададим разбиение буфера с вершинами треугольников граней куба на атрибуты:

const coord = 0;

const index = 1;

GL.enableVertexAttribArray(coord);

GL.vertexAttribPointer(coord, 3, GL.FLOAT, false, 16, 0);

GL.enableVertexAttribArray(index);

GL.vertexAttribPointer(index, 1, GL.FLOAT, false, 16, 12);

Метод vertexAttribPointer задаёт связь между указанным атрибутом и буфером,

связанным в текущий момент с назначением ARRAY_BUFFER.

Его параметры:

- номер атрибута (нумеруются от нуля и до

GL.MAX_VERTEX_ATTRIBS - 1) - размерность атрибута (от 1 до 4)

- формат данных в памяти

- интерпретация целочисленных форматов (для формата

FLOATне играет роли) - расстояние между атрибутами соседних вершин в байтах (можно поставить 0; при этом расстояние будет автоматически вычислено как произведение размерности на размер одной единицы данных указанного формата)

- номер начального байта атрибута начальной вершины

Формат FLOAT, как нетрудно заметить, требует 4 байта на число.

Теперь напишем вершинный и фрагментный шейдеры:

Вершинный шейдер

#version 300 es

in vec3 coord;

in float index;

out vec3 color;

void main() {

vec3 position = coord + vec3(0, 0, 7);

gl_Position = vec4(position.xy, -1, position.z);

switch (int(index)) {

case 0:

color = vec3(0.3, 0.3, 0.3);

break;

case 1:

color = vec3(0.3, 0.3, 0.7);

break;

case 2:

color = vec3(0.3, 0.7, 0.3);

break;

case 3:

color = vec3(0.3, 0.7, 0.7);

break;

case 4:

color = vec3(0.7, 0.3, 0.3);

break;

case 5:

color = vec3(0.7, 0.3, 0.7);

break;

case 6:

color = vec3(0.7, 0.7, 0.3);

break;

case 7:

color = vec3(0.7, 0.7, 0.7);

break;

default:

color = vec3(0, 0, 0);

}

}

Фрагментный шейдер

#version 300 es

precision highp float;

in vec3 color;

out vec4 frag_color;

void main() {

frag_color = vec4(color, 1);

}

Особенности шейдеров

Вершинный и фрагментный шейдеры пишутся на языке GLSL, весьма сильно напоминающем язык Си (но не являющимся таковым).

Ключевое отличие GLSL от Javascript и Python — статическая типизация.

А именно, каждая переменная, каждая функция и каждая формула имеет тип

(в динамически типизированных языках тип имеют только значения формул).

В языке Си (и GLSL) объявления переменных выглядят как тип имя_переменной;

Функция main — точка входа в программу (именно она автоматически

выполняется при запуске программы). Код вне функций (кроме объявления

переменных) запрещён. В качестве типа возвращаемого значения у неё стоит

«пустой» тип void.

Перед функцией main определено два входа-атрибута

in vec3 coordin float index

и один выход

out vec3 color

который путём линейной интерполяции между тройкой вершин будет передан фрагментному шейдеру. Названия этих переменных абсолютно иррелевантны, но входные переменные фрагментного шейдера должны называться так же, как соответствующие им выходы вершинного шейдера.

Основная задача вершинного шейдера — выставить значение глобальной

переменной gl_Position. Это — четырёхмерный вектор,

компоненты которого имеют следующий смысл:

- смещение вершины вправо от наблюдателя

- смещение вершины вверх от наблюдателя

- необработанная глубина вершины

- смещение вершины вдаль от наблюдателя

Полученный треугольник проецируется на экран, который отождествляется с квадратом \(2\times 2\), удалённым от наблюдателя вдаль на 1. Центр этого квадрата имеет в качестве экранных координат пару нулей. Экранные координаты правого верхнего края — пара единиц.

Задача фрагментного шейдера — выставить цвет — значение

глобальной переменной типа out vec4, название которой произвольно

(и задаётся в соответствующей строчке программы).

В отличие от вершинного шейдера, во фрагментном требуется явно задать

точность вычислений командой precision. Например, команда

precision highp float;

задаёт для чисел типа float точность не ниже стандартной одинарной

(1 бит знака, не менее 8 бит экспоненты, не менее 23 бит мантиссы).

Расчёт глубины пикселя

Применяется только если в управляющей программе была включена проверка глубины при помощи команды

GL.enable(GL.DEPTH_TEST);

Фрагментный шейдер может (но не обязан) выставить

глубину пикселя — значение глобальной

переменной gl_FragDepth. Оно должно быть в пределах от 0 до 1 (значения

вне этих границ заменяются на соответствующую границу).

Если фрагментный шейдер не выставляет gl_FragDepth, то используется

величина, вычисленная при помощи необработанных глубин соответствующей

тройки вершин:

- каждая необработанная глубина делится на её смещение вдаль

- полученные глубины линейно интерполируются по спроецированному на экран треугольнику

Для того, чтобы таким образом вычисленные глубины пикселей получались линейно зависящими от реальных удалений соответствующих им точек от наблюдателя, необработанные глубины тоже должны линейно зависить от удаления вершин от наблюдателя. Говоря проще, если четвёртая координата вершины обозначена \(w\), то формула для вычисления необработанной глубины должна иметь вид

\[ \alpha w + \beta \]

При этом вычисленная глубина будет иметь вид

\[ \alpha + \frac{\beta}{W} \]

где \(W\) — смещение точки, соответствующей пикселю, вдаль от наблюдателя.

Вычисленная глубина допускается в пределах от -1 до 1 (и линейно отображается

на диапазон от 0 до 1: если d — вычисленная глубина, то

по умолчанию gl_FragDepth = (1.0+d)/2.0;).

Если не хочется задумываться над видом формулы, можно взять просто \(\alpha=0\) и \(\beta = -1\) или \(\alpha=\beta=1\).

При этом точки, расположенные между наблюдателем и экраном (напомним, что экран находится на удалении 1 от наблюдателя) рисоваться не будут.

Внимание! Независимо от того, включена ли проверка глубины, и выставлен

ли явно gl_FragDepth, по умолчанию не рисуются все точки, у которых

вычисленная глубина оказывается вне диапазона от -1 до 1.

Сборка программы

Для того, чтобы использовать вершинный и фрагментный шейдеры, их нужно «собрать» в единую «программу». Далее мы будем называть шейдеры и результат их сборки управляемыми программами, а программу, которая их собирает и запускает (и которую мы сейчас пишем на Javascript) — управляющей.

Собрать шейдеры можно сделать при помощи следующих функций:

function compileShader(source, type) {

let glType = type;

if (type === 'vertex') { glType = GL.VERTEX_SHADER; }

else if (type === 'fragment') { glType = GL.FRAGMENT_SHADER; }

const shader = GL.createShader(glType);

GL.shaderSource(shader, source);

GL.compileShader(shader);

if (!GL.getShaderParameter(shader, GL.COMPILE_STATUS)) {

console.error(`SHADER TYPE ${type}`);

console.error(GL.getShaderInfoLog(shader));

return null;

}

return shader;

}

function buildProgram(vsSource, fsSource, attributes) {

const vs = compileShader(vsSource, 'vertex');

if (vs === null) { return null; }